Інформаційні процеси пошук, обробка, зберігання і передача

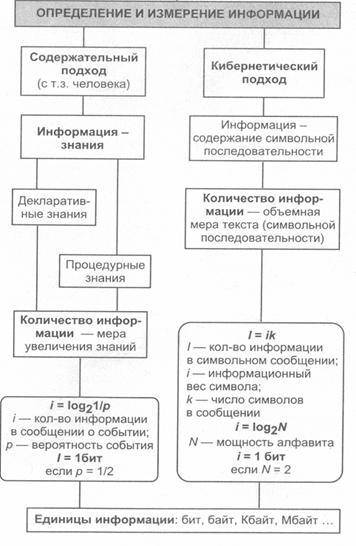

Основні підходи до визначення поняття «інформація». Вимірювання інформації в теорії інформації і в техніці. Обчислення кількості інформації.

Термін «інформація» походить від латинського informatio. що означає роз'яснення, інформування, виклад. З позиції матеріалістичної філософії інформація є відображенням реального світу за допомогою відомостей (повідомлень). Повідомлення - це форма подання інформації у вигляді мови, тексту, зображення, цифрових даних, графіків, таблиць і т.д. У широкому сенсі інформація - це загальнонаукове поняття, яке включає в себе обмін інформацією між людьми, обмін сигналами між живою і неживою природою, людьми і пристроями.

Поняття інформація є одним з фундаментальних у сучасній науці. Однак формально визначити це поняття досить складно (як поняття «точка» або «пряма» в геометрії). У побутовому розумінні з терміном «інформація» зазвичай асоціацію-цііруются деякі відомості, дані, знання і т.п.

Повідомлення від джерела до одержувача завжди передається за допомогою якої-небудь середовища, що є в такому разі «каналом зв'язку» (звук - повітря, текст - лист і т.п.).

Людині властиво суб'єктивне сприйняття інформації через деякий на-бор її властивостей: важливість, достовірність, своєчасність, доступність і т.д. У цьому сенсі одне й те саме повідомлення, передане від джерела до одержувача, може передавати інформацію в різному ступені.

Представники атрибутивної концепції (Абдеев, Баженов, Петрушенко, Урсул та ін.) Вважають, що інформація - атрибут матерії, тобто властивість будь-якої системи об'єктивної реальності.

Представники антропоцентричної концепції (Цідря, Афанасьєв, Шрейдер та ін.) Вважають, що інформацію не можна розглядати поза людиною і поза суспільством; вона розглядається як сенс сигналу, отриманого системою із зовнішнього світу.

Вимірювання інформації (різні підходи)

Найбільш часто використовуються наступні два способи вимірювання інформації: об'ємний і імовірнісний.

Об'ємний підхід. У двійковій системі числення знаки 0 і 1 будемо називати бітами (від англійсько-го вираження BInary digiTs - виконавчі цифри). Віддають перевагу саме двійковій системі числення тому, що в технічному пристрої найбільш просто реалізувати два протилежних фізичних стану: намагнічене / НЕ намагнічене, вкл. / Викл. заряджена / не заряджена і ін.

Обсяг інформації, записаної двійковими знаками в пам'яті комп'ютера або на зовнішньому носії інформації, підраховується просто за кількістю необхідних для такого запису двійкових символів. При цьому неможливість-но нецілим число бітів.

Для зручності використання введені і більші, ніж біт, одиниці коли-пра інформації. Так, двійкове слово з восьми знаків містить один байт інформації, 1024 байта утворюють кілобайт (КБ), 1024 кілобайт - мегабайт (Мбайт), а 1024 мегабайта - гігабайт (Гбайт).

Ентропійний (імовірнісний) підхід. Цей підхід прийнятий в теорії інформації та кодування. Даний спосіб вимірювання виходить з наступної моделі: одержувач повідомлення має певне уявлення про можливі наступах деяких подій. Ці уявлення в загальному випадку недостовірні і виражаються можливостями, з якими він очікує ту чи іншу подію. Загальна міра невизначеностей називається ентропією. Ентропія характеризується деякою математичною залежністю від сукупності ймовірності настання цих подій.

Кількість інформації в повідомленні залежить від того, наскільки зменшилася цей захід після отримання повідомлення: чим більше ентропія системи, тим більше ступінь її невизначеності. Що поступає повідомлення повністю або частково знімає цю невизначеність, отже, кількість інформації можна вимірювати тим, наскільки знизилася ентропія системи після отримання повідомлення. За міру кількості інформації приймається та ж ентропія, але з протилежним знаком.

Розглянемо приклад обчислення кількості інформації повідомлення про настання одного з N рівноймовірно подій. Позначимо чисельну величину, що вимірює невизначеність (ентропію) через H. Величини N і H пов'язані деякою функціональною залежністю: H = f (N). Ця функція, очевидно, є зростаючою, неотрицательной і певною при всіх значеннях 1, 2, ..., N.

Позначимо через H1 невизначеність, наявну до здійснення події. Через H2 - невизначеність після настання події. Тоді за I - кількість інформації про результат досвіду - приймемо різниця невизначеностей до і після досвіду: I = H1 - H2.

У разі, коли отриманий конкретний результат, що була невизначеність знята (тому що H2 = 0). Таким чином, кількість отриманої інформації збігається з початковою ентропією. Невизначеність, укладена в досвіді збігається з інформацією про результат цього досвіду.

Визначимо функцію H = f (N). Варіюватимемо N (число можливих результатів) і M (число дослідів). Загальна кількість випадків одно X = N M. Кожен результат - деякий вектор довжини M. складається з знаків 1, 2, ..., N.

Ситуацію з проведенням М дослідів можна розглядати як якусь складну систему, що складається з незалежних один від одного підсистем - одноразових дослідів. Ентропія такої системи в М разів більше, ніж ентропія однієї системи (так званий «принцип адитивності ентропії»): f (N M) = M f (N).

Прологаріфміруем ліву і праву частини рівності X = N M. Отримаємо:

Підставивши отримане для M значення в рівність f (N M) = M f (N), отримаємо:

Позначивши позитивну константу. отримаємо формулу:.

Отримана формула називається формулою Хартлі.

Важливим при введенні будь-якої величини є питання про те, що приймати за одиницю її виміру. Очевидно, Н буде дорівнює одиниці при N = 2. Інакше кажучи, в якості одиниці приймається кількість інформації, пов'язане з проведенням досвіду, що складається в отриманні одного з двох рівноймовірно исхо-дов (наприклад, кидання монети). Така одиниця кількості інформації називається бітом.

Все N результатів розглянутого вище досвіду є рівноімовірними і по-цьому можна вважати, що на «частку» кожного результату доводиться одна N -я частина загальної невизначеності досвіду:. При цьому ймовірність i -гo результату Рi; дорівнює, очевидно, 1 / N. Таким чином:

Ця ж (остання) формула приймається за міру ентропії в разі, коли ймовірності різних результатів досвіду неравновероятни (тобто значення Рi можуть змінюватися). Ця формула називається формулою Шеннона.

Зауваження: під обсягом даних VД в повідомленні тут мається на увазі кількість символів в цьому повідомленні (тобто те, що розуміється під бітом при об'ємному підході).

Приклад 1. Визначення кількості інформації, пов'язане з появою кожного символу в повідомленні російською мовою. Будемо вважати, що N = 34 (33 букви і пробіл). тоді:

Приклад 2. Однак, в словах української мови (як і в інших мовах) різні літери зустрічаються неоднаково часто. Якщо скористатися таблицею ймовірностей частоти вживання різних знаків українського алфавіту, то за формулою Шеннона можна обчислити значення H. Отриманий результат буде трохи менше обчисленого раніше (4,72), так як величина Н. обчислюється за формулою Хартлі, є максимальною кількістю інформації, яка могла б припадати на один знак.

Зауваження: Для одного і того ж повідомлення при використанні різних підходів можуть виходити різні значення кількості інформації (але приблизно рівні). Кількість інформації, отримане за формулами Хартлі-Шеннона, не може бути більшою за кількість інформації, отриманого об'ємним методом.

Приклад 3. Розглянемо алфавіт, що складається з двох знаків 0 і 1. Якщо вважати, що зі зна-ками 0 і 1 в двійковому алфавіті пов'язані однакові ймовірності їх появи (Р0 = Р1 = 0,5), то кількість інформації на один знак при довічним кодується-вання дорівнюватиме Н = log2 2 = 1 біт. Таким чином, кількість інформації (в бітах), укладену в довічним слові, дорівнює числу двійкових знаків в ньому.

Інші (менш відомі) способи вимірювання інформації

Алгоритмічний підхід. Будь-якого повідомлення можна приписати кількісну характеристику, яка відображатиме складність (розмір) програми, яка дозволяє його зробити. Так як є багато різних обчислювальних машин та мов програмування, тобто різних способів завдання алгоритму, то для визначеності задається деяка конкретна машина, наприклад машина Тьюринга. Тоді як кількісної характеристики повідомлення можна взяти мінімальну кількість внутрішніх станів машини, потрібних для відтворення даного повідомлення.

Семантичний підхід. Для вимірювання смислового змісту інформації, тобто її кількості на семантичному рівні, найбільше визнання отримала Тезаурусний міра. яка пов'язує семантем-етичні властивості інформації зі здатністю користувача приймати надійшло повідомлення. Для цього використовується поняття «тезаурус користувача».

Тезаурус - це сукупність відомостей, якими володіє пользо-ватель або система.

Максимальна кількість семантичної інформації Ic споживач набуває при узгодженні її смислового змісту S зі своїм тезаурусом S р. коли надходить інформація зрозуміла користувачеві і несе йому раніше не відомі (відсутні в його тезаурус) відомості.

При оцінці семантичного (змістовного) аспекту інформації необхідно прагнути до узгодження величин S і Sp.

Відносною мірою кількості семантичної інформації може служити коефіцієнт змістовності С. який визначається як відношення кількості семантичної інформації до її об'єму:.

Прагматичний підхід. Цей захід визначає корисність інформації (цінність) для досягнення користувачем поставленої мети. Цей захід також величина відносна, обумовлена особеннос-тями використання цієї інформації в тій чи іншій системі. Цінність інформації доцільно вимірювати в тих же самих одиницях (або близьких до них), в яких изме-ряется цільова функція.